Winter Leaves è una investigazione sui rapporti che intercorrono fra armonia e timbro.

Winter Leaves, infatti, si basa su 3 suoni, ognuno formato da 5 sinusoidi le cui frequenze hanno fra loro un intervallo fisso. Tutti suoni sono costruiti sulla stessa fondamentale (47.5 Hz, circa SOL). Le altre 4 componenti hanno rapporti di 2 (8va) nel primo suono, di 2.24 (9a magg.) nel secondo e 2.8856 (intervallo non temperato corrispondente a una 11ma crescente) nel terzo.

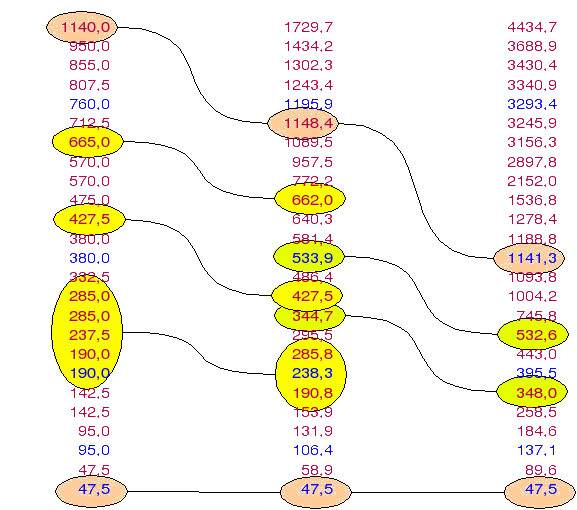

I 3 suoni base, quindi, hanno le seguenti componenti sinusoidali:

- Rapporto 2 -> 47.5, 95, 190, 380, 760 (8ve sovrapposte)

- Rapporto 2.24 -> 47.5, 106.4, 238.3, 533.9, 1195.9 (9ne sovrapposte)

- Rapporto 2.8856 -> 47.5, 137.1, 395.5, 1141.3, 3293.4 (11me cresc. sovrapposte).

A questo punto è chiaro che spettri di questo tipo possiedono sia una valenza timbrica che armonica. Nel primo caso il suono è associato alla consonanza perfetta, nel secondo, a una dissonanza interpretabile nell’ambito del sistema temperato e nel terzo a una dissonanza non temperata.

Ognuno di questi spettri, sintetizzato con una semplice additiva a 5 oscillatori, viene poi arricchito dal punto di vista acustico grazie a un processo di ring modulation fra le 5 componenti base prese 2 a 2. Con questo metodo si generano altre componenti le cui frequenze sono pari alla somma e alla differenza fra quelle di base, come è tipico del modulatore ad anello. Si ottengono, così, altre frequenze che vengono utilizzate sia come componenti spettrali che come ‘note’ su cui articolare il discorso melodico/armonico.

Ne consegue che il rapporto 2 genera, per somma e differenza, solo componenti armoniche; il 2.24 genera un mix di componenti armoniche e inarmoniche e il 2.8856 genera solo componenti inarmoniche.

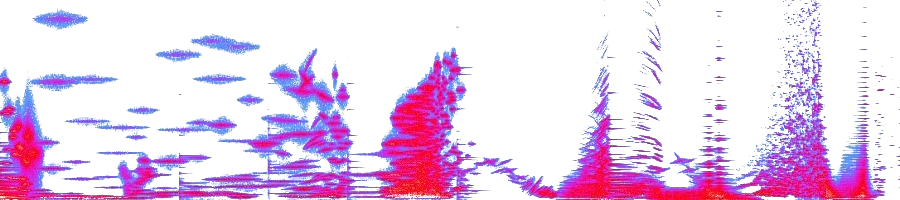

Nella seguente tabella sono riportati i 3 insiemi di frequenze che possono essere visti sia come organizzazione melodico/armonica che timbrica. In effetti, Winter Leaves è totalmente costruito su di essi in quanto:

- la tessitura melodico/armonica è basata sui 3 insiemi considerati come scale, usate nella maggior parte dei casi da sole e sovrapposte solo nelle fasi di passaggio fra un insieme e l’altro (passaggi, che, comunque, sono molto frequenti nel corso del brano)

- la tessitura timbrica utilizza solo queste frequenze come componenti sinusoidali dei suoni, anche qui un insieme alla volta (non esiste un suono che sia un mix di frequenze provenienti da più insiemi) con sovrapposizioni nei punti di passaggio. Per ottenere queste sonorità sono state programmate in Music360 (l’antenato di CSound) 3 tipologie di strumenti:

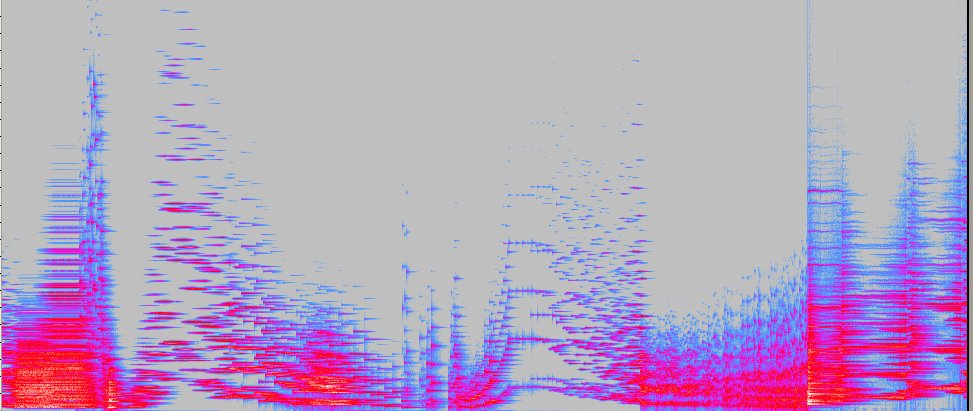

- sintesi additiva sulle 5 componenti base (genera solo le componenti blu, sfondo giallo)

- sintesi ring modulation fra una o più coppie di frequenze base (genera le componenti rosse con o senza le coppie generatrici)

- varie combinazioni dei 2 suddetti, fino a uno strumento che genera un suono contenente tutte le frequenze di un insieme

Esistono, quindi, sia spettri con una organizzazione di tipo normale in cui le componenti più basse sono anche le più forti e l’ampiezza cala andando verso gli acuti, che spettri a bande laterali in cui le componenti centrali hanno maggiore ampiezza.

| Ratio 2 |

Ratio 2.24 |

Ratio 2.8856 |

|||

| Freq. Base |

Freq. ± | Freq. Base |

Freq. ± | Freq. Base |

Freq. ± |

| 1140.0 | 1729.7 | 4434.7 | |||

| 950.0 | 1434.2 | 3688.9 | |||

| 855.0 | 1302.3 | 3430.4 | |||

| 807.5 | 1243.4 | 3340.9 | |||

| 760.0 | 1195.9 | 3293.4 | |||

| 712.5 | 1148.4 | 3245.9 | |||

| 665.0 | 1089.5 | 3156.3 | |||

| 570.0 | 957.5 | 2897.8 | |||

| 570.0 | 772.2 | 2152.0 | |||

| 475.0 | 662.0 | 1536.8 | |||

| 427.5 | 640.3 | 1278.4 | |||

| 380.0 | 581.4 | 1188.8 | |||

| 380.0 | 533.9 | 1141.3 | |||

| 332.5 | 486.4 | 1093.8 | |||

| 285.0 | 427.5 | 1004.2 | |||

| 285.0 | 344.7 | 745.8 | |||

| 237.5 | 295.5 | 532.6 | |||

| 190.0 | 285.8 | 443.0 | |||

| 190.0 | 238.3 | 395.5 | |||

| 142.5 | 190.8 | 348.0 | |||

| 142.5 | 153.9 | 258.5 | |||

| 95.0 | 131.9 | 184.6 | |||

| 95.0 | 106.4 | 137.1 | |||

| 47.5 | 58.9 | 89.6 | |||

| 47.5 | 47.5 | 47.5 |

Analizzando i 3 insiemi si nota che le proprietà delle frequenze base si riflettono nelle frequenze generate per somma e differenza. In particolare:

- il rapporto 2 genera solo componenti armoniche

- il rapporto 2.24 genera sia componenti armoniche che inarmoniche

- il rapporto 2.8856 genera quasi esclusivamente componenti inarmoniche

In tal modo è possibile passare gradualmente da campi di suoni armonici a campi di suoni parzialmente o totalmente inarmonici accostando e/o sovrapponendo aree in cui le figurazioni musicali si articolano su insiemi diversi. La seguente immagine evidenzia le aree comuni utilizzabili come ponte.

Winter Leaves ha ottenuto una menzione al 9° International Electroacoustic Music Awards di Bourges (1981) ed è stato analizzato in dettaglio in una tesi di Dottorato in Musique et musicologie du XXème siècle presso l’Université de Paris IV – Sorbonne e Scienze della Musica presso l’Università degli Studi di Trento (XVI ciclo) [Laura Zattra, Science et technologie comme sources d’inspiration au CSC de Padoue et à l’IRCAM de Paris, 2003]. Qui potete leggere un riassunto in italiano dell’analisi tratto dalla suddetta tesi.

Potete ascoltare il brano in streaming cliccando qui. Durata circa 8’30”.

NB: MP3 compresso a bitrate 128. Originale su vinile [ConTempo Musical Editions INSOUND 2 – Record LP Edipan PRC S2016].

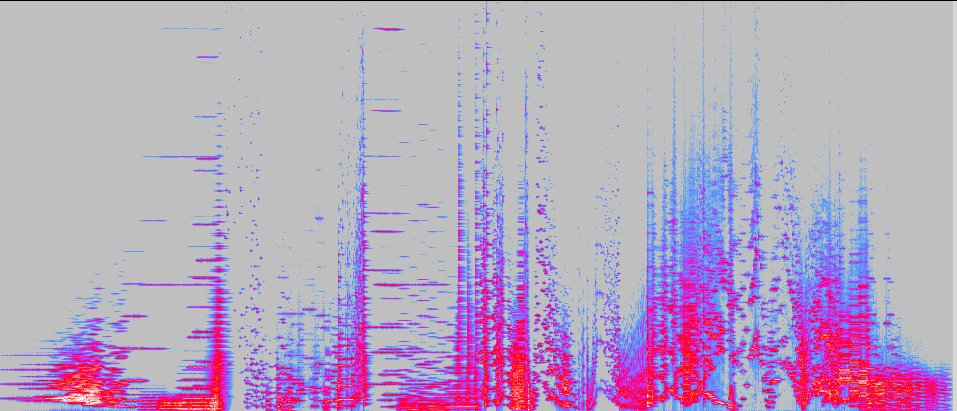

Agnes Heginger, soprano e Karlheinz Essl, elettronico, hanno registrato poco meno di un anno fa, all’Essl Museum in Vienna, questo disco, dal titolo Out of the Blue.

Agnes Heginger, soprano e Karlheinz Essl, elettronico, hanno registrato poco meno di un anno fa, all’Essl Museum in Vienna, questo disco, dal titolo Out of the Blue.

Philippe Manoury

Philippe Manoury

No, non si tratta della sonata 29 op. 106 di Ludwig Van, ma di un recente lavoro elettroacustico di

No, non si tratta della sonata 29 op. 106 di Ludwig Van, ma di un recente lavoro elettroacustico di

La prima volta che incontrai Barry Truax (nella foto a 2/3 anni), al CSC di Padova alla fine degli anni ’70, io ero uno studente e lui era già un guru della computer music che aveva al suo attivo il POD (un software per la composizione assistita da computer) e una convincente sistematizzazione compositiva della modulazione di frequenza e alcuni brani che la sfruttavano, come Sonic Landscape e Androginy.

La prima volta che incontrai Barry Truax (nella foto a 2/3 anni), al CSC di Padova alla fine degli anni ’70, io ero uno studente e lui era già un guru della computer music che aveva al suo attivo il POD (un software per la composizione assistita da computer) e una convincente sistematizzazione compositiva della modulazione di frequenza e alcuni brani che la sfruttavano, come Sonic Landscape e Androginy.